“The [technology] also wants what every living system wants; to perpetuate itself, 让自己继续前进. 随着它的成长,这些内在的需求变得越来越复杂和强大.——凯文·凯利

这篇博文是我上一篇博文的分支, 人工智能——一把达摩克利斯之剑?” 2019年12月出版. 在此期间, 人工智能的治理被宣布为首要任务,并为其迫切需要提供了理由. 四年过去了, 很多思想论文, 开放的框架, 法规和立法表明了人工智能治理的必要性,并为实现这一目标提供了广泛的步骤.

现在的挑战是,要仔细阅读大量的文献,并找到为特定组织量身定制的人工智能治理的操作方法. 在这方面作了一次尝试,以便对读者有所帮助, 尤其是那些在GRC兄弟会的人. NIST的AI风险管理框架,发表于2023年1月.

评估人工智能风险

人工智能系统的设计目的是与 不同程度的自主权. 人工智能带来的主要风险是什么?

人工智能的15大风险 如下所示,有:

- 缺乏透明度

- 偏见和歧视

- 隐私问题

- 道德困境

- 安全风险

- 权力集中

- 对AI的依赖

- 裁员

- 经济上的不平等

- 法律和监管方面的挑战

- 人工智能军备竞赛

- 失去人际关系

- 错误信息和操纵

- 意想不到的后果

- 存在风险

值得注意的是,人工智能可以产生独特的风险,而不是普遍的风险,这取决于使用它的组织的性质.

AI可信度

NIST规定了值得信赖的AI的以下特征:

- 有效可靠

- 安全

- 安全且有弹性

- 问责和透明

- 可解释可解释

- 隐私-enhanced

- 公平,但有害的偏见得到了控制

根据NIST, “一个高度安全但不公平的系统, 准确但不透明和无法解释的系统, 不准确,但很安全, privacy-enhanced, 透明的系统都是不受欢迎的. 一种全面的风险管理方法要求 平衡利弊 其中的可信度特征.”

上面的关键词是“平衡取舍”.”

AI风险管理框架核心

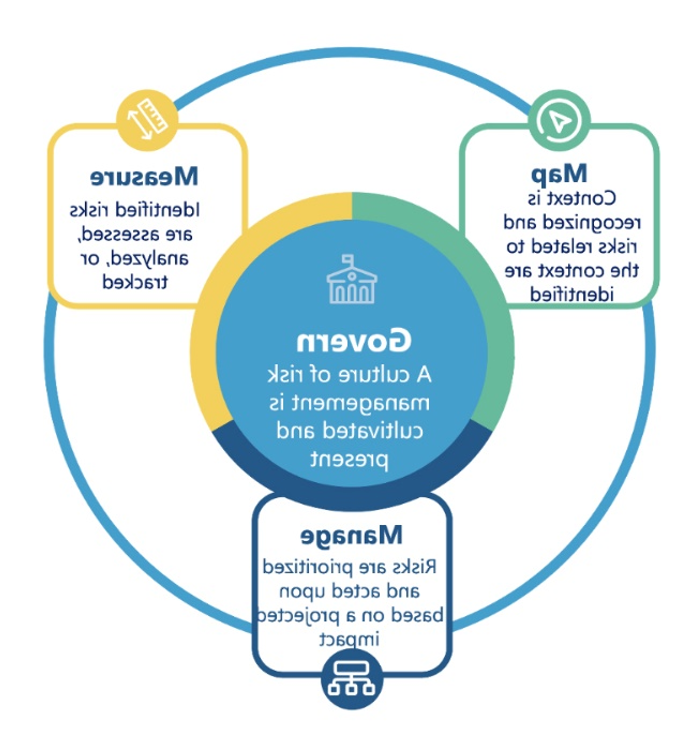

NIST规定的RMF框架包括四个功能,如下图所示:

- 管理

- Map

- 测量

- 管理

治理被设计成一个横切功能,通知并注入到其他三个功能中. 人工智能RMF的核心功能应在考虑多学科视角后进行, 可能包括组织外部的视图.

以下是人工智能治理的一些关键步骤:

- 在风险度量中应考虑可信度的七个特征.

- 每个特征都应该根据上下文进行定量或定性的评估, 但最好是定量的和百分比的. 根据风险收益成本分析或法规或行业要求,可以达到平衡.

- 对于人工智能系统的可信度特征,应考虑包括内部和外部利益相关者在内的多学科利益相关者观点, 特别是对于那些具有重大社会经济影响的人工智能系统.

- 每个RMF核心功能的类别和子类别应作为指导方针,并在行使每个功能时加以应用.

- 重要的是,这些指导方针应该基于上下文而不是严格的清单来考虑.

- 审计界应将人工智能审计视为“管理审计”或“社会审计”,并应用这些原则, 而不是财务审计或内部审计. 无论需要审计的AI组件是什么,这一点都适用.

人工智能原理操作化案例研究

一个案例研究如何 微软设立了人工智能伦理委员会 管理其人工智能发展的简要细节在这里. 2018年3月, 微软宣布,将成立一个由公司人工智能和研究部门的总裁和执行副总裁领导的工程与研究中的人工智能和伦理(AETHER)委员会. 到2019年初,以太坊扩展到代表人工智能、伦理和工程和研究中的影响. 以太坊分为七个工作组:

- 敏感的使用 评估自动化决策对人们生活的影响

- 偏见与公平 评估对少数民族和弱势群体的影响

- 可靠性和安全性 以确保人工智能系统能够抵御对抗性攻击

- 人的注意与认知 监控算法的注意力入侵和说服能力

- 可理解性和解释性 为机器学习和深度学习模型提供透明度

- 人类人工智能交互与协作 加强人们与人工智能系统的互动

- 工程最佳实践 为人工智能系统开发周期的每个阶段推荐最佳实践.

建立以太坊的决定向员工发出了一个非常明确的信息, 用户, 客户和合作伙伴都知道,微软打算将其技术提升到更高的标准.

特定行业指南可以加强人工智能治理

人工智能给人类带来了很多好处和优势, 但相关的风险需要以全面的方式加以管理. 因此, 遵循一个全面的框架将使组织能够防止做出临时决定,并确保各利益相关者之间更好的信誉和信任.

随着人工智能的发展, 监管机构正在推出开放框架,以适应各种环境和行业. 像ISACA这样的专门机构可以利用其专业知识和知识库,为这些框架提供针对特定行业的指导方针.

作者附言:所表达的意见是作者自己的观点,并不代表他所隶属的组织或认证机构的观点.